Intel recorta el tiempo de prueba de sus chips con Hadoop

La apuesta del fabricante norteamericano por el análisis predictivo y el Big Data le permitirá ahorrar alrededor de 30 millones de dólares y reducir en un 25% el tiempo de prueba de sus chips.

Intel IT ha desarrollado una solución de análisis predictivo que puede reducir el tiempo de prueba de los chips en un 25% y ahorrar a la compañía 30 millones de dólares durante el próximo año.

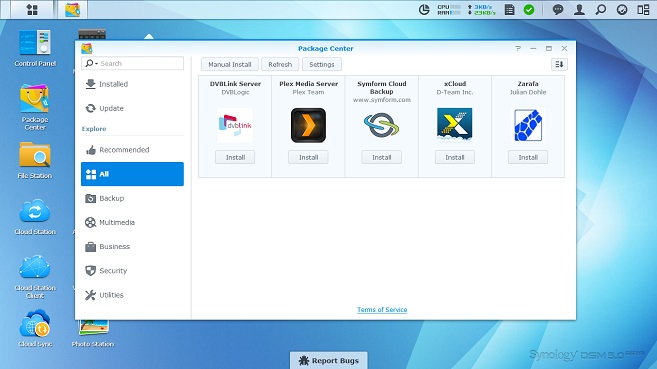

Cada chip de Intel que sale del proceso de producción es objeto de una verificación de calidad rigurosa, que implica una compleja serie de pruebas. La compañía ha estado invirtiendo en la infraestructura de Big Data con el objetivo de acelerar este proceso, optando finalmente por una plataforma multi-tenant combinada con un data warehouse appliance para Apache Hadoop.

Con la nueva plataforma, Intel es capaz de reunir información histórica durante la fabricación y combinar nuevas fuentes de datos que previamente habían sido demasiado difíciles de controlar. De este modo, un pequeño equipo de cinco personas fue capaz de recortar tres millones de dólares a la hora de poner a prueba una sola línea de procesadores Core de Intel en 2012.

En base a estos resultados, era esperado que Intel expandiera esta tecnología al resto de sus líneas de producción. En ese sentido, Intel espera lograr los mencionados ahorros de 30 millones entre 2013 y 2014. Los resultados iniciales de las pruebas también indican que estas capacidades serán fundamentales para alcanzar el objetivo de Intel de disminuir el tiempo de pruebas en un 25%.

Intel está ahora tratando de identificar nuevos campos en donde aplicar sus capacidades de procesar el Big Data, así como implantar soluciones de Business Intelligence que mejoren la eficiencia de su producción. Entre otras medidas, el proveedor norteamericano ha puesto en marcha un portal autoservicio de BI para que los grupos de negocios de Intel puedan llevar a cabo su propio análisis y rápidamente recibir los resultados pertinentes para su toma de decisiones.

"El análisis predictivo es lo que buscamos con nuestras capacidades de hardware, obteniendo el mayor partido del Big Data", explica Chris Shaw, director de Intel IT para EMEA. "El siguiente paso será utilizar sensores en tiempo real en el medio ambiente, en nuestro caso, podrían ser sensores dentro de nuestras propias líneas de fabricación”.

Asimismo, Intel está trabajando con Apache para construir una infraestructura de nube híbrida basada alrededor de Hadoop. El objetivo de esta alianza es ayudar a Apache a entender cómo aprovechar al máximo las características del hardware de Intel y obtener información sobre los tipos de capacidades que se necesitan para apoyar Hadoop.